Esta es la manera más fácil. Pulsando en el siguiente botón, se creará un contenedor con el repositorio de la clase y todos los archivos de datos que se necesitan.

Preferiblemente en Linux/Mac. Clona el repositorio en tu PC en un directorio sin espacios:

git clone https://github.com/luisbelloch/data_processing_course.git

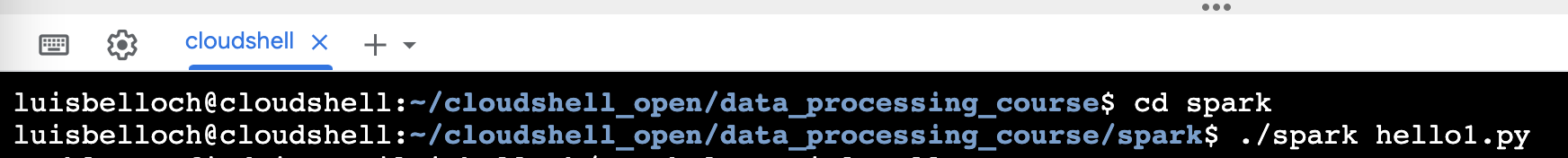

cd data_processing_course/spark

./spark compras_con_mas_de_un_descuento.py

El script ./spark es equivalente a hacer:

docker run --rm -ti -w /upv \

-v $(pwd):/upv -v $(pwd)/../data:/upv/data \

luisbelloch/spark spark-submit /upv/compras_con_mas_de_un_descuento.py

Después de clonar el repositorio, ejecuta:

docker run -v $(pwd)/data:/home/jovyan/data -p 8888:8888 -p 4040:4040 jupyter/pyspark-notebook

Luego navega a http://127.0.0.1:8888/lab. El token para acceder se muestra al arrancar el contenedor.